Erstveröffentlichung, 2016

In diesem Artikel bekommst Du einen Überblick über die 10 häufigsten SEO-Fehler, die Du bei der Suchmaschinenoptimierung Deiner Website vermeiden sollten.

Im Vergleich zu anderen Online Marketing-Disziplinen ist die Suchmaschinenoptimierung ein Bereich, der sprunghaften Veränderungen unterliegt. Googles Algorithmus ändert sich konstant, um bessere Ergebnisse für seine Benutzer:innen zu liefern – was wiederum zu häufigen Veränderungen der Rankings einer Website führen kann. Sei es durch einen neu hinzu gewonnen Link, eine neue Seite mit Inhalten oder einen neuen Konkurrenten, der in den Markt drängt.

Gerade im SEO-Bereich sollte man daher ständig auf dem Laufenden bleiben. Nicht mehr aktuelle SEO-Praktiken, Maßnahmen, die gegen die Google Richtlinien verstoßen oder Black-Hat-Techniken können schnell zu manuellen oder algorithmischen Abstrafungen führen, die dramatische Konsequenzen für die Online-Präsenz eines Unternehmens bedeuten und signifikante Besucher:innen-Rückgänge zur Folge haben können.

SEO-Fehler #1: Unnatürliche externe Verlinkungen

Link Building ist zu einem Minenfeld geworden. Der Aufbau von unnatürlichen Verlinkungen kann algorithmische oder manuelle Abstrafungen zur Folge haben, die sich in dem Verlust einzelner Rankings bis zur kompletten Deindexierung einer Website in Suchmaschinen manifestieren. „Aufbau von unnatürlichen Verlinkungen“ bedeutet, dass über verschiedene Techniken künstliche Links auf eine Website aufgebaut werden, um die Rankings in Suchmaschinen zu steigern.

Dazu gehören:

- der übermäßige Austausch von Verlinkungen

- reziproke Verlinkungen

- Link Wheels

- die Nutzung von überoptimierten Linktexten

- Linkkäufe

- automatisierter Linkaufbau durch Software

- und viele weitere

Google hat eine eigene FAQ-Seite ins Leben gerufen, um das Verständnis von unnatürlichen Link-Schemata bei Webmastern zu schärfen.

Links sind allerdings auch weiterhin einer der wichtigsten Rankingfaktoren bei Google. Dies wurde erst kürzlich durch John Mueller, Web Trend Analyst bei Google, bestätigt. Googles Matt Cutts nannte Links einst die „Online-Reputation“ des Unternehmens. Es geht um die Qualität der Empfehlungen, die für Suchmaschinen u.a. in Form von Links getroffen werden.

Folgende typische Fehler, die im Bereich des Linkbuildings den größten Schaden verursachen, können ein Trigger für das Penguin Update sein:

- Eine Überoptimierung der Linktexte: Das Linkprofil der Website weist einen überproportional hohen Anteil an Links mit exakten Linktexten auf. Es wird also zum Beispiel immer mit dem Begriff „Glätteisen“ auf eine Unterseite eines Online-Shops verlinkt, die zum Begriff „Glätteisen“ bei Suchmaschinen ranken soll.

- Quantität der Qualität der Verlinkungen bevorzugen: Eine hohe Anzahl von Backlinks, die eine niedrige Qualität besitzen, können einer Website mehr Schaden zufügen als man denkt. Sie besitzen in der Regel keinerlei Wert, da sie weder einen Mehrwert für den User bieten noch die Rankings signifikant verbessern. Sie führen lediglich zu Google Penalties, die die organische Sichtbarkeit einer Domain dramatisch verschlechtern können.

- Deeplink-Ratio: Backlinks sollten nicht nur auf die Homepage gesetzt werden. Die Deeplink-Ratio (Verhältnis zwischen Links auf die Homepage und Links auf tiefergehende Seiten) sollte sich an das branchenübliche Verhältnis angleichen, um natürlich zu wirken. Links auf tieferliegenden Seiten können deren Ranking deutlich verbessern. Suchmaschinen betrachten das Linkprofil als Ganzes: Links auf interne Seiten können auch zu einer Verbesserung des Rankings der Homepage führen, indem z.B. Metriken wie die Domain Popularität oder die Domain Authority erhöht werden.

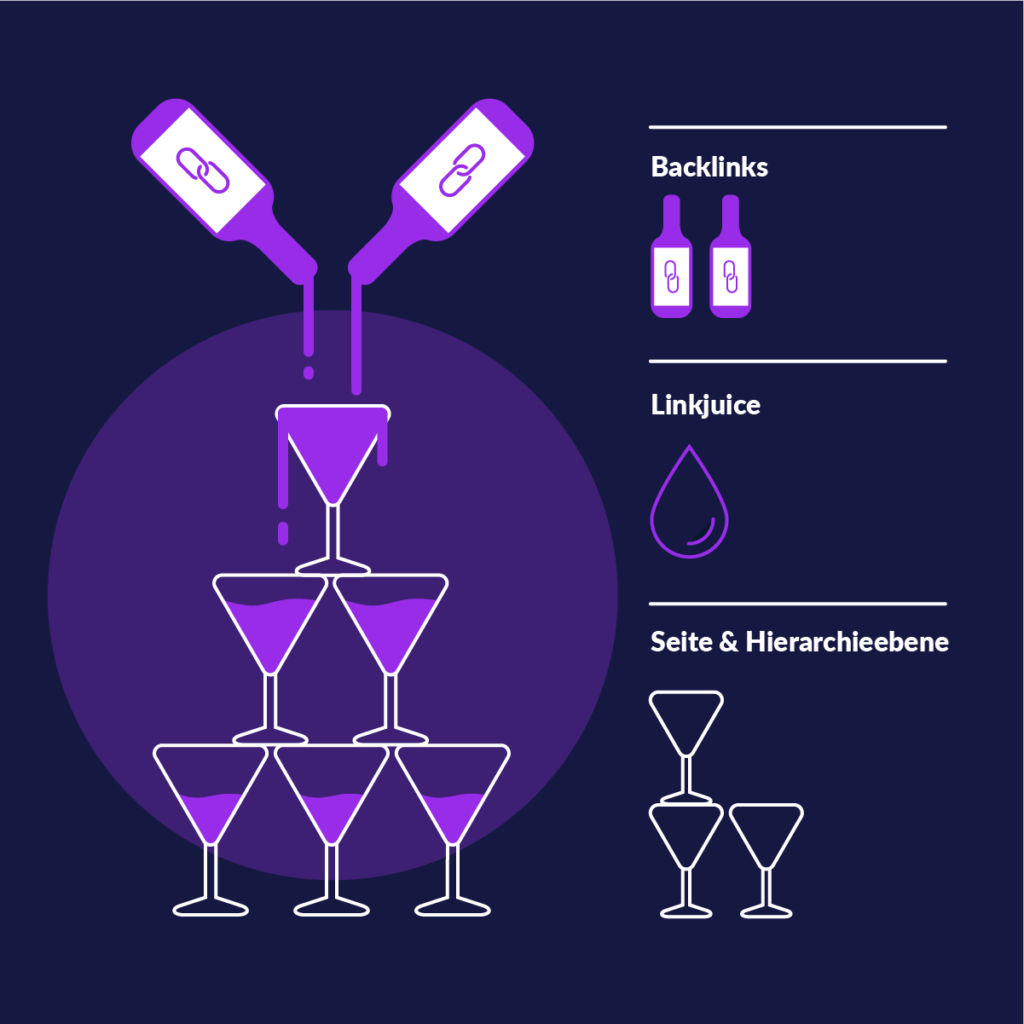

SEO-Fehler #2: Schlechte interne Verlinkungen

Linkjuice richtig vererben

Verlinkungen in Navigationsleisten und Footern

Der richtige Anchor Text ist entscheidend

SEO-Fehler #3: Keyword Stuffing

Keywords sind nicht komplett „tot“. Man kann Keywords immer noch sehr gut dazu nutzen, um Content-Ideen zu entwickeln und Seiten zu gesuchten Themen zu erstellen. Der User sucht nach Themen und Fragestellungen und vermittelt diese der Suchmaschine, indem er Keywords eingibt. Die Suchmaschine ist aber inzwischen in der Lage zu verstehen, welche Suchintention ein/e Benutzer:in hat, der/die ein bestimmtes Keyword eingibt. Die Keyword-Frequenz hat also an Relevanz enorm eingebüßt, nichtsdestotrotz ist es ratsam, auch weiterhin der Keyword-Analyse einen Fokus zu geben.

Filling pages with keywords or numbers results in a negative user experience, and can harm your site's ranking.

Empfehlung:

Man sollte beim Schreiben von Texten für das Web nicht an die Keyword-Platzierung denken. Vielmehr sollten die Texte so geschrieben werden, dass sie dem/der Leser:in einen wirklichen Mehrwert bieten und ihm/ihr wichtige Fragestellungen zu einem Thema beantworten. Dazu gehört auch eine korrekte Interpunktion, keine Rechtschreib- und Grammatikfehler, eine Strukturierung der Texte, z.B. über Listen oder Tabellen (wo sinnvoll), und eine Ergänzung der Inhalte durch Bild- und Videomaterial.

Es ergibt natürlich auch weiterhin Sinn, Keywords an wichtigen Stellen (z.B. in den Überschriften) unterzubringen. Dies sollte aber bereits beim Schreiben der Texte automatisch erfolgen. Wenn ich den wichtigen Suchbegriff nicht im Inhalt selbst sowie vereinzelt in einigen Überschriften unterbringen kann, dann habe ich möglicherweise das Thema verfehlt. Eine Keyword-Analyse kann Aufschluss darüber geben, wonach die User häufig suchen. Diese kann eine gute Orientierung bieten, um den Besucher:innen die Inhalte zu bieten, nach denen sie suchen.

SEO-Fehler #4: Thin and Duplicate Content

Thin Content

Wenn eine Website kontinuierlich „schlechten“ oder Thin Content produziert, dann kann dies nachhaltigen Schaden an der Reputation der Website verursachen. Nicht alleine in den Suchmaschinen, sondern auch bei den Benutzern, die diese Inhalte lesen. Mit schlechtem Content sind zum Beispiel Inhalte gemeint, die ungemein kurz, ungenau beschreibend, nicht hilfreich, zu generell oder schlecht recherchiert sind. Mit dem Ausdruck „Thin Content“ referenziert der Search Marketer in der Regel auf Inhalte, die dem Benutzer keinerlei Mehrwert bieten. Diese können heutzutage deutlich schneller erkannt werden als noch vor einigen Jahren. Google definiert „Thin Content“ als Inhalt, der dem Benutzer wenig oder keinen Mehrwert bietet. Dazu gehören:

- Automatisch erstellter Inhalt

- Affiliate Seiten ohne Mehrwert für den User

- Inhalte von anderen Seiten, zum Beispiel gescrapte Inhalte oder Gastbeiträge mit niedriger Qualität

- Doorway Pages

- Jeglicher Versuch „Thin Content“ auf einer Website hinzuzufügen, kann zu einer Abstrafung führen, selbst wenn dies nur eine einzige Seite betrifft, kann Google eine manuelle Abstrafung dieser Seite über den Bereich „Manuelle Spam-Maßnahmen“ in der Google Search Console verhängen.

The days of SEO being a game of outsmarting algorithms are over. Today content strategy and valuable, sustainable strategies are essentials, not just tricks and links.

Adam Audette, Chief Knowledge Officer, RKG

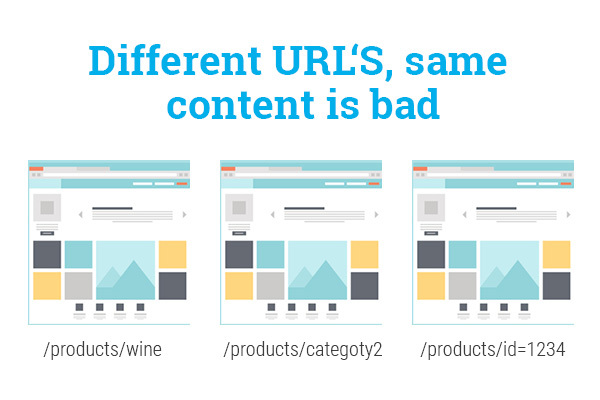

Duplicate Content

Es ist zunächst wichtig zu wissen, dass vereinzelte Probleme mit Duplicate Content nicht direkt zu schlechteren Rankings oder einer Abstrafung führen. Eine Behebung dieser Probleme ist allerdings häufig sehr einfach möglich. Folgende Aspekte können hinsichtlich DC kritisch werden bzw. benötigen eine genauere Betrachtung:

- 301-Redirects (z. B. TLD auf www.)

- Umgang mit Top-Level-Domains für länderspezifische Inhalte

- Content Syndication

- Standard Wiederholungen und „leere“ Seiten

- Filterungen

- URL-Struktur und Kategorisierung

Digital Arrow

Melde Dich jetzt zu unserem Newsletter „Digital Arrow“ an, mit dem Du die brandheißen digitalen News zuerst erhältst!

SEO-Fehler #5: Fehler beim Website Relaunch

Die 10 häufigsten Fehler beim Website-Relaunch, die häufig zu beobachten sind:

- Fehlende Weiterleitungen trotz Änderungen an der URL Struktur

- Interne Links werden nicht aktualisiert

- Die robots.txt blockiert den Crawler

- Der Robots-Meta-Tag enthält den Wert „noindex„

- Die Bilder wurden nicht mit umgezogen oder liegen noch unter einer anderen URL-Struktur, die nach dem Relaunch nicht mehr abrufbar ist

- Der Google Analytics Code wurde auf der neuen Website nicht verbaut

- Es existieren noch unnötige Ressourcen (z. B. JS und CSS) im Quellcode, die nur in der Testversion benötigt wurden

- Die ehemals gute OnPage-Optimierung wurde nicht mit auf die Website übertragen

- Externe Links zeigen noch auf die alte URL-Struktur

- Es wurde nicht ausreichend getestet und nach dem Relaunch gemonitored. Im schlimmsten Fall bemerkt man die Fehler erst nach einem kompletten Verlust der Rankings.

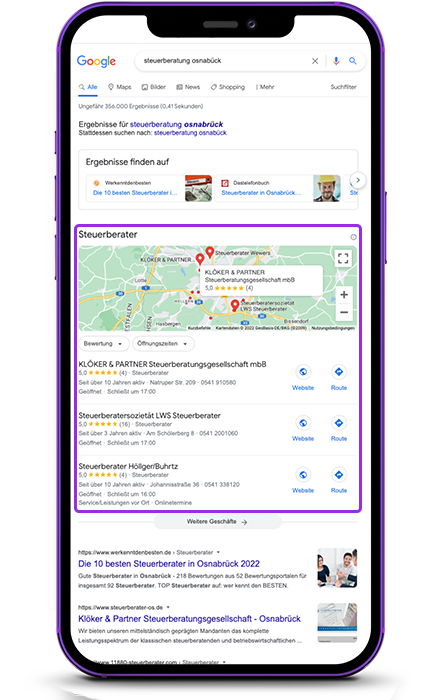

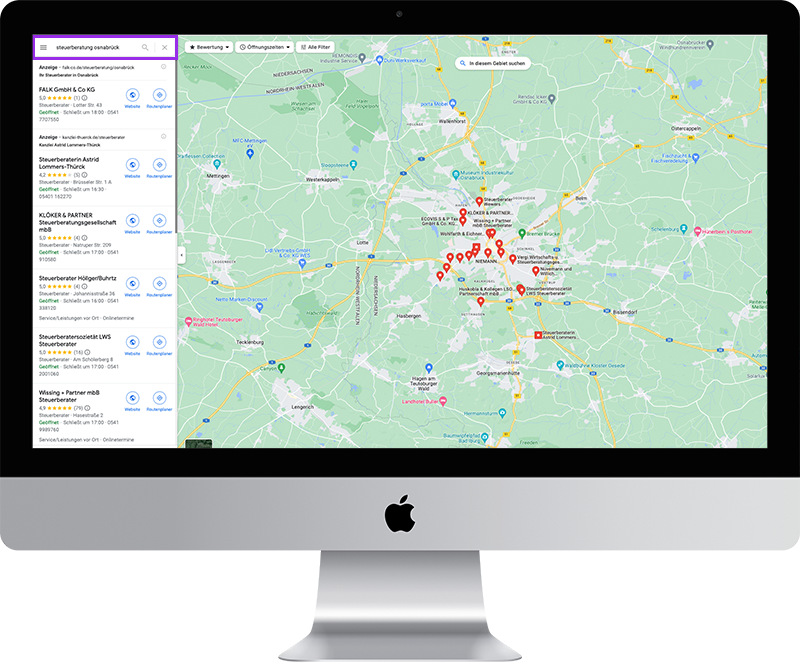

SEO-Fehler #6: Keine Optimierung für die lokale Suche

Man sollte sich also klarmachen, welche Maßnahmen man bereits für die lokale Suche vornimmt. Für das Local SEO bieten sich beispielsweise folgende Punkte an:

1. Spezifische Landing Pages für Standorte innerhalb der Website

2. Listings in Suchmaschinen, u.a. Google My Business

3. Lokale Auffindbarkeit durch Verzeichniseinträge erhöhen

Tipp: Diese Auflistung bezieht sich auf typische SEO-Fehler. In Kombination mit der lokalen und regionalen Steuerungsmöglichkeit von Google AdWords lassen sich hier noch bessere Ergebnisse erzielen. Sprich unsere Kolleg:innen hierzu gerne an.

SEO-Fehler jetzt beheben!

mso digital ist Deine Agentur für lokale und regionale Suchmaschinenoptimierung.

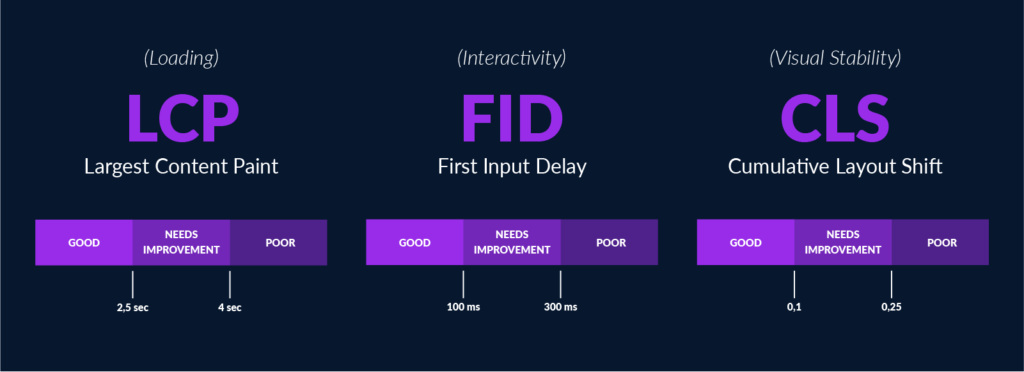

SEO-Fehler #7: Ignorieren der Core Web Vitals

Largest Contentful Paint – Die Ladegeschwindigkeit

Speeding up your website is a great thing to do in general. Visitors to your site will be happier (and might convert more or use your site more), and a faster web will be better for all.

Matt Cutts, Head of Webspam a.D., Google

3 wesentliche Bereiche, die durch hohe Ladezeiten negativ beeinflusst sein können:

- Suchmaschinenranking

- User Experience

- Conversion Rate

First Input Delay – Die Interaktivität

Cumulative Layout Shift – Die Stabilität

Doch was verbirgt sich hinter diesen unerwarteten Bewegungen?

SEO-Fehler #8: Hidden Content

Methoden zum Verstecken von Content

Textblöcke auf der Seite verstecken

Entweder setzte man dazu die Schriftgröße eines Absatzes, der mit relevanten Keywords vollgestopft wurde, einfach auf 0. So blieb dieser für die User ungesehen. Oder aber man passte die Schriftfarbe dem Hintergrund an, sodass der Text, wie ein Chamäleon auf der Seite verschwand. Beide Formen waren zumindest damals sehr erfolgreich.

Doch mittlerweile sollte man zwingend die Finger von dieser Methode lassen, denn Suchmaschinen strafen Keyword Stuffing mittels verstecktem Inhalt vehement ab. Diese Form von Blackhat SEO ist jedoch immer noch verbreitet und der/die ein oder andere Betreiber:in von Webseiten denkt, er/sei könne Google und Co ein Schnippchen schlagen.

Backlinks verbergen

Auch Backlinks lassen sich auf ähnlicher Weise verstecken. Der User hat letztlich keinerlei Kenntnis über die versteckten Elemente, doch für die Suchmaschine sind diese auf der Seite vorhanden. Auch hinter Bildern lassen sich Links oder Textelemente einfach verbergen.

Abstrafung bei Hidden Content

Erlaubter Hidden Content

SEO-Fehler #9: Fehlendes Tracking und Monitoring der Website Performance

In my experience, which includes conducting 200 link audits in 2013, most reconsideration requests are turned around in 30 days or less. That said, it's reasonable to conclude that 95 percent of all websites receiving a penalty don't even bother to attempt a recovery.

Chuck Price, Founder Measurable SEO

Tipp: Für tiefergehende Monitorings im Bereich der technischen OnPage-Optimierung oder im Bereich der OffPage-Optimierung (Link Alerts) existieren inzwischen einige Tool-Anbieter (beispielsweise URL-Monitor oder ahrefs am Markt, die dieses Monitoring übernehmen und bei Auffälligkeiten Benachrichtigungen an den Webmaster senden.

SEO-Fehler #10: Schlechtes responsive Design

Was ist responsives Design?

Technische Umsetzung von responsivem Design

Schlechtes responsives Design

Doch auch bei der responsiven Gestaltung von Websites passieren eine ganze Reihe verschiedener Fehler. Wir haben für die einige der häufigsten Missverständnisse aufgelistet.

- Footer nicht angepasst

Auf dem Desktop sieht ein gut gefüllter Footer extrem gut und einladend aus. Er dient dem User als Navigation und auch als Touchpoint für weitere Interaktionen. In der mobilen Version hingegen ist ein ausladender Footer hingegen eher störend. - Inhalte nicht ausblenden

Es gibt die Möglichkeit Inhalte auf mobilen Geräten auszublenden und nur die Kernbotschaft darzustellen. Das kann beispielsweise bei sehr langen Texten Sinn ergeben. Während Nutzer:innen auf der Desktop-Version einen Artikel deutlich übersichtlicher überblicken können, muss bei der mobilen Version lange runtergescrollt werden, ehe man die Information findet, die man sucht. Durch das ausblenden unnötiger Informationen bietet man dem User die Möglichkeit schneller seine Suchintention zu befriedigen. - Schriftgrößen nicht anpassen

In manchen Fällen kann es Sinn ergeben die Schriftgröße der Texte auf das jeweilige Endgerät anzupassen. Stellt man beispielsweise fest, dass die Lesbarkeit eines Textblocks bei einer Schriftgröße von 12px auf dem Smartphone leidet, empfiehlt es sich, hier eine andere Schriftgröße zu wählen. - Keine responsiven Bilder

Bilder sollten in jedem Fall responsiv sein. Oftmals bringt die Verkleinerung von Bilder jedoch mit sich, dass Details verloren gehen. Hier empfiehlt es sich, das Bild zur Vergrößerung anklickbar zu machen. In diesem Fall kann das Bild über ein modulares Dialogfeld separat von den Inhalten betrachtet werden. - Webseiten für mobile Endgeräte erstellen

Dieser Punkt klingt erst einmal ein wenig widersprüchlich. Doch bei genauerer Betrachtung wird deutlich, was damit gemeint ist. Eine Website wird klassischerweise für den Desktop erstellt und dann auf mobile Endgeräte runterskaliert. Würde man den umgekehrten Weg wählen, lässt sich das Design nicht ohne weiteres hochskalieren.

Fazit: SEO-Fehler sind vermeidbar

SEO Agentur mso digital

Hast Du weitere Fragen oder benötigst Du Unterstützung bei der SEO-Optimierung Deiner Website? Dann melde Dich gerne bei uns!

4 Kommentare

Hallo,

guter Beitrag, gefällt mir sehr. Eine Frage hätte ich aber noch: Müsste aus eurer Sicht nicht „fehlendes responsive Design“ mithinein? Da ja immer mehr User über ihr Mobilgerät suchen, finde ich das essentiell.

Hallo BIZ,

vielen Dank für deinen Hinweis! Da würden wir dir absolut zustimmen. Dieser Beitrag ist tatsächlich schon etwas älter. Wir werden ihn zeitnah bearbeiten und deinen Input berücksichtigen.

Vielen Dank für diesen tollen Blog Artikel! Finde ich sehr informativ 🙂 Beste Grüße aus Fürth, Nick Freund

Hallo Nick,

freut uns zu lesen, dass dir unser Artikel gut gefallen hat.

Beste Grüße

Anastasia